「チャットGPT使ってみたけど、嘘ばかりつくのはどうして?」

「チャットGPTのいうことはデタラメばかりなの?」

本記事はこんな疑問に答える記事です。

チャットGPTを使っていると、デタラメや嘘ばかりを回答してくることがあります。

なぜチャットGPTは嘘ばかりついてしまうのでしょうか?

今回は、なぜチャットGPTがデタラメや嘘ばかりついてしまうのか、について詳しく解説します。

チャットGPTはなぜ嘘ばかりついてしまうのか?

チャットGPTの回答で嘘ばかりついてしまう原因は以下の通りです。

以下に一つずつ詳しく解説します。

データソースが制限されているから

チャットGPTは、膨大なデータを学習していますが、そのデータはインターネット上のテキストから収集されています。

もちろんインターネット上には誤った情報が存在するため、それらも学習データの一部となってしまいます。

そのため、チャットGPTは時にデタラメな情報や嘘ばかりの回答になってしまう時があるわけです。

ユーザーからの入力の解釈が様々だから

チャットGPTはユーザーの入力を解釈する時、文脈や意図を正確に理解するレベルにまでは到達していません。

特にジョークやニュアンスなど、言葉の微妙な側面を人間のように理解することができません。

そのため、意図しないデタラメな回答や嘘ばかりの答えを返してくることがあります。

偏った情報も正しい情報として覚えてしまうから

チャットGPTはユーザーから入力された情報の影響を大きく受けます。

ユーザーから入力された情報が偏っていたり、間違っていたりすると、それをそのまま学習し反映してしまうことがあります。

その結果、チャットGPTは事実に基づかないデタラメや、嘘ばかりの回答をしてしまう時があります。

※月額375円でYouTubeプレミアムに入る方法があります

月額375円でYouTubeプレミアムに入る方法があります。年間8,980円もお得になるので節約したい方は試してみてください。→月額375円でYouTubeプレミアムを使用する方法

チャットGPTでは情報の精査が必要

ここまで説明した通り、チャットGPTは様々な理由から嘘やデタラメを回答してしまう時があります。

したがって、チャットGPTの回答を全て鵜呑みにするのではなく、この情報は本当に正しいかどうかを自分自身で精査する力が必要になります。

具体的な例を紹介します。

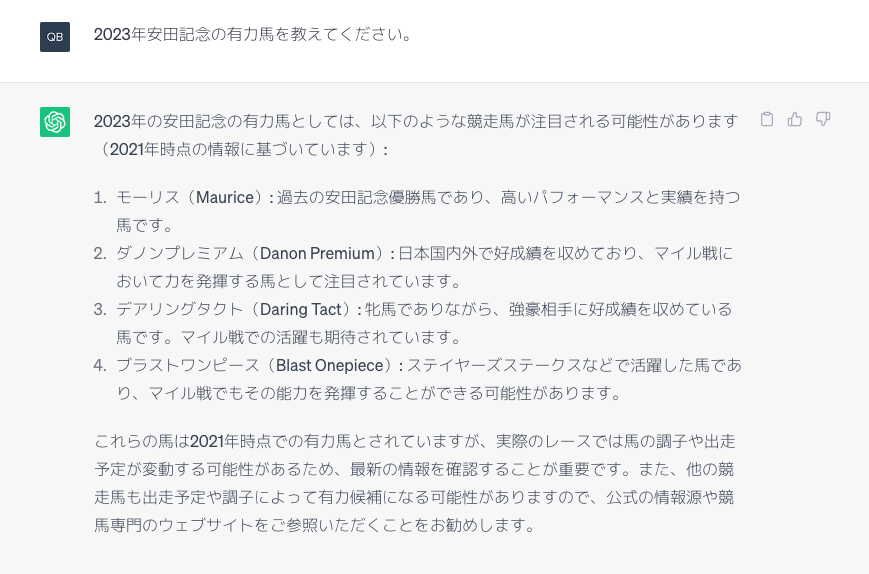

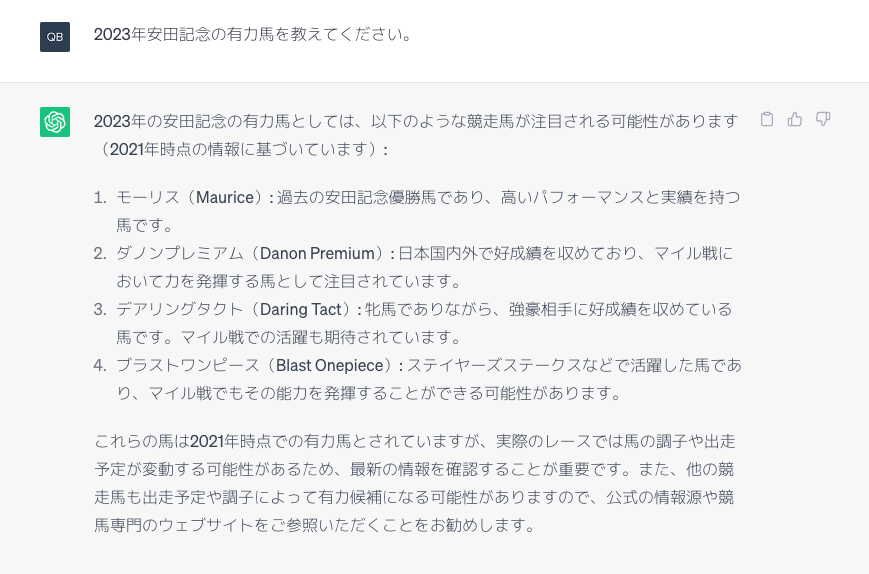

以下、チャットGPTに「2023年安田記念の有力馬を教えてください」と質問してみました。(2023/6/4、未来の競馬の重賞です)

すると、4頭の有力馬を答えてくれました。

しかし、これらの馬は2023年安田記念を走りません(笑)

- モーリス:2017年引退

- ダノンプレミアム:2017年引退

- デアリングタクト:現役だが安田記念は走らない

- ブラストワンピース:2022年引退

というか、ほとんど引退した馬を回答していてめちゃくちゃです。

自分が詳しいジャンルであれば、このように間違った事を回答していると瞬時に気づけます。

しかし、詳しくないジャンルを質問した時は、チャットGPTの回答が絶対に正しいと鵜呑みにせず、情報の精査は行うようにしましょう。

まとめ

今回は、なぜチャットGPTが嘘ばかりついてしまうのか、紹介しました。

チャットGPTが嘘ばかりの回答やデタラメな回答をしてしまう原因は以下です。

自分が詳しくないジャンルの質問をチャットGPTにした時は、その情報が正しいのかどうか、きちんと確認するようにしましょう。

※月額375円でYouTubeプレミアムに入る方法があります

月額375円でYouTubeプレミアムに入る方法があります。年間8,980円もお得になるので節約したい方は試してみてください。→月額375円でYouTubeプレミアムを使用する方法